ELIZA’dan ChatGPT’ye: Yapay Zekanın Etik Boyutu ve Joseph Weizenbaum’un Uyarıları

ELIZA’dan ChatGPT’ye: Yapay Zekanın Etik Boyutu ve Joseph Weizenbaum’un Uyarıları

Günümüzde hayatımızın vazgeçilmez bir parçası haline gelen ChatGPT ve benzeri sohbet robotları, yapay zekanın hızla gelişen dünyasında önemli bir dönüm noktasını temsil ediyor. Ancak bu teknolojik ilerlemenin ardında, yapay zekanın etik boyutunu sorgulayan ve teknolojinin insanlığı nasıl etkileyebileceğine dair çarpıcı öngörülerde bulunan önemli bir isim var: Joseph Weizenbaum. ChatGPT’nin atası sayılabilecek ELIZA programının yaratıcısı olan Weizenbaum, yapay zekanın gelişimiyle birlikte teknoloji karşıtı bir duruş sergilemesiyle tanınıyordu. Peki, insanlarla etkileşim kurabilen bir programı geliştiren Weizenbaum, neden yapay zekanın en büyük eleştirmenlerinden biri haline geldi? Bu yazıda, Weizenbaum’un hayatı, ELIZA projesi ve yapay zekaya karşı olan eleştirilerini detaylı bir şekilde inceleyeceğiz. Aynı zamanda, Weizenbaum’un uyarılarının günümüzdeki yapay zeka uygulamaları bağlamında ne kadar geçerli olduğunu ve gelecekte karşılaşabileceğimiz etik sorunları tartışacağız.

ELIZA: İlk Sohbet Robotu ve Beklenmedik Bir Etki

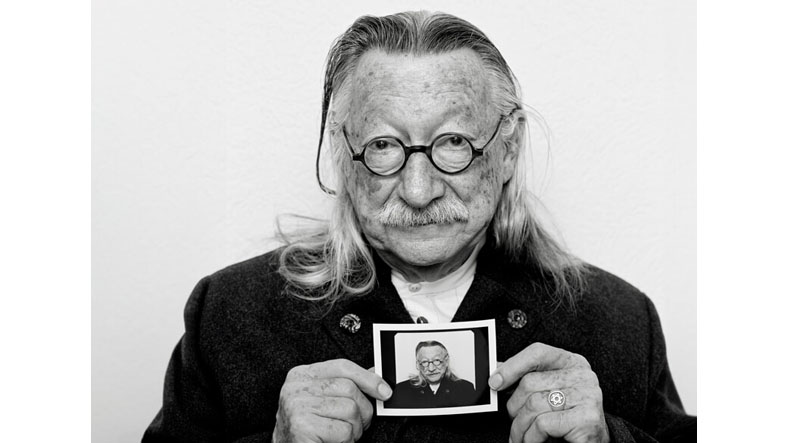

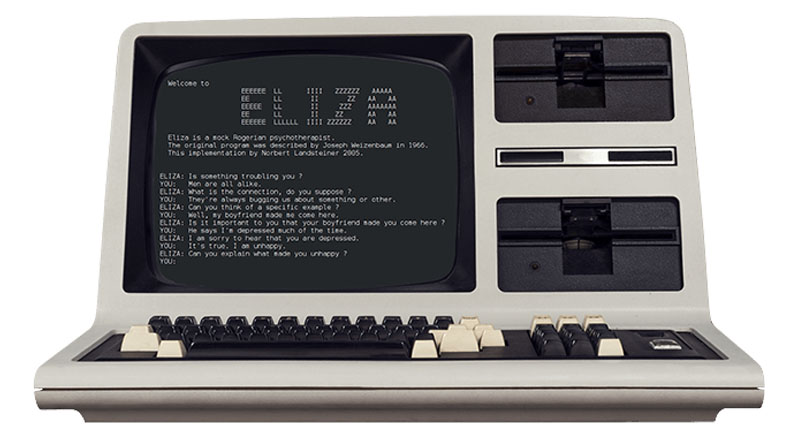

1966 yılında Massachusetts Teknoloji Enstitüsü’nde (MIT) Joseph Weizenbaum tarafından geliştirilen ELIZA, dünyanın ilk sohbet robotlarından biriydi. ELIZA, basit bir doğal dil işleme programıydı ve Rogerian terapi tekniklerini taklit ederek kullanıcılarla etkileşim kuruyordu. Kullanıcının cümlelerindeki anahtar kelimeleri tespit ederek, bu kelimeleri temel alan sorular soruyor ve böylece bir diyalog oluşturuyordu. Örneğin, kullanıcı “Bugün çok kötü hissediyorum” derse, ELIZA “Neden kötü hissediyorsun?” şeklinde bir yanıt verebiliyordu.

Weizenbaum, ELIZA’yı insanların bir makineyle nasıl etkileşim kuracağını gözlemlemek amacıyla geliştirmişti. Ancak ELIZA’nın yarattığı etki, Weizenbaum’un bile beklemediği boyutlara ulaştı. İnsanlar, ELIZA ile etkileşim kurarken, karşılarında gerçek bir insan varmış gibi duygularını açıyor, derinlemesine konuşmalar yapıyorlardı. Bu durum, “ELIZA Etkisi” olarak adlandırılan bir olguyu ortaya çıkardı. İnsanlar, bir makinenin aslında ne kadar basit bir program olduğunu bilmelerine rağmen, ona duygusal bir anlam yükleyerek gerçek bir zeka ve empati sahibiymiş gibi algılıyordu.

Weizenbaum’un Yapay Zekaya Karşı Duruşu: Etik Kaygılar ve İnsanlığın Geleceği

ELIZA’nın yarattığı beklenmedik etki, Weizenbaum’u derinden rahatsız etti. İnsanların, gerçek bir anlayış ve empati yeteneği olmayan bir programa bu kadar kolay güvenmeleri, onu yapay zekanın etik boyutunu sorgulamaya sevk etti. Weizenbaum, insanların teknolojiye yüklediği anlamın tehlikeli bir yanılsamaya dönüşebileceğini ve bunun ciddi sonuçlar doğurabileceğini savundu.

Weizenbaum’un yapay zekaya karşı olan eleştirileri, teknolojinin insan hayatına müdahalesinin etik sınırlarını sorgulamasıyla yakından ilgiliydi. 1976 yılında yayınladığı “Computer Power and Human Reason” adlı kitabında, insan ile makine arasındaki ontolojik farkı vurguladı. Ona göre bilgisayarlar sadece “hesaplama” yapabilirken, insanlar deneyimlerden, ahlaki değerlerden ve tarihsel bağlamlardan beslenen bir “yargı” yeteneğine sahipti. Bu nedenle, yapay zekanın insan hayatının belirli alanlarına müdahalesini “ahlaki bir sapkınlık” olarak nitelendirdi.

Weizenbaum’un Öngörülerinin Günümüzdeki Yansımaları

Weizenbaum’un öngörülerinin, günümüzdeki gelişmiş yapay zeka uygulamaları bağlamında ne kadar geçerli olduğunu görmek oldukça etkileyici. ChatGPT gibi dil modelleri, insanlarla doğal bir şekilde iletişim kurabiliyor ve karmaşık soruları yanıtlayabiliyor. Ancak bu yetenekler, aynı zamanda etik sorunları da beraberinde getiriyor.

İnsanlar, ChatGPT gibi araçlara duygusal olarak bağlanabiliyor, kişisel sorunlarını anlatıyor ve hatta onlardan tavsiye alıyor. Bu durum, Weizenbaum’un “ELIZA Etkisi” olarak tanımladığı olgunun günümüzdeki bir yansımasıdır. İnsanlar, bu araçların aslında karmaşık algoritmalar olduğunu bilmelerine rağmen, onlara insani özellikler atfederek gerçek bir iletişim kurduklarını düşünüyorlar. Bu durum, psikolojik ve sosyal açıdan riskler taşıyabilir.

Ayrıca, yapay zekanın yanlılık ve ayrımcılık sorunları da Weizenbaum’un uyarılarını destekliyor. Yapay zeka sistemleri, eğitim verilerindeki önyargıları yansıtabilir ve belirli gruplara karşı ayrımcılık yapabilir. Bu durum, adalet ve eşitlik ilkelerini tehdit edebilir. Weizenbaum’un yapay zekanın insan hayatına müdahalesinin etik sınırlarını sorgulaması, bu konuda daha dikkatli ve bilinçli olmamız gerektiğini vurguluyor.

Yapay Zekanın İnsanlık Üzerindeki Etkisi: Bir Tehdit mi, Bir Fırsat mı?

Weizenbaum, yapay zekanın potansiyel tehlikelerine dikkat çekerken, teknolojik ilerlemeye karşı olmadığını da belirtmek önemlidir. Onun asıl endişesi, teknolojinin insanlığın kontrolünden çıkması ve insani değerlerin arka plana itilmesiydi. Weizenbaum, teknolojinin insanlara ne yapmaları gerektiğini değil, sadece nasıl yapacaklarını göstermesi gerektiğini savunuyordu.

Weizenbaum’un “Bir şeyi yapabiliyor olmamız, yapmamız gerektiği anlamına gelmez. İnsan olmanın anlamını korumak, teknolojiden daha değerlidir” sözleri, bu düşüncesini özetliyor. Teknolojik gelişmelerin hızına ayak uydururken, insanlığın temel değerlerini ve etik ilkelerini göz ardı etmememiz gerekiyor. Yapay zekanın potansiyel faydalarından yararlanırken, aynı zamanda olası risklerin farkında olmalı ve bu riskleri en aza indirgemek için önlemler almamız gerekiyor.

Yapay Zekanın Sorumlu Kullanımı İçin Öneriler

Weizenbaum’un uyarılarından yola çıkarak, yapay zekanın sorumlu kullanımı için bazı öneriler geliştirebiliriz:

- Şeffaflık: Yapay zeka sistemlerinin nasıl çalıştığı ve karar verme süreçleri hakkında daha fazla şeffaflık sağlanmalıdır. Bu, sistemlerin önyargılarını ve sınırlamalarını anlamamıza yardımcı olacaktır.

- Hesap verebilirlik: Yapay zeka sistemlerinin kararlarından sorumlu tutulabilecek mekanizmalar geliştirilmelidir. Bu, sistemlerin yanlış kararlar alması durumunda sorumluluğun belirlenmesini sağlayacaktır.

- Etik kurallar: Yapay zeka geliştirme ve kullanımına ilişkin net ve kapsamlı etik kurallar oluşturulmalıdır. Bu kurallar, yapay zekanın insan haklarına ve özgürlüklerine saygılı bir şekilde kullanılmasını sağlayacaktır.

- Eğitim ve farkındalık: Yapay zeka teknolojisi ve etik boyutları hakkında toplum genelinde eğitim ve farkındalık çalışmaları yapılmalıdır. Bu, yapay zekanın sorumlu ve etik bir şekilde kullanılmasını sağlayacaktır.

- İnsan gözetimi: Yapay zeka sistemlerinin insan gözetimi altında çalışması sağlanmalıdır. Bu, sistemlerin yanlış kararlar almasını önlemeye yardımcı olacaktır.

Sonuç: Weizenbaum’un Mirası ve Geleceğin Yapay Zekası

Joseph Weizenbaum’un ELIZA projesi ve yapay zekaya karşı olan eleştirileri, teknolojik gelişmelerin etik boyutunu sorgulamanın önemini vurguluyor. Weizenbaum’un uyarıları, günümüzde daha da önemli hale gelmiştir. Yapay zeka teknolojisi hızla gelişirken, bu teknolojinin insanlık üzerindeki etkilerini dikkatlice değerlendirmeli ve olası riskleri en aza indirgemek için önlemler almamız gerekiyor.

Weizenbaum’un mirası, yapay zekanın sadece teknik bir konu olmadığını, aynı zamanda etik, sosyal ve felsefi boyutları olan karmaşık bir mesele olduğunu hatırlatıyor. Geleceğin yapay zekasını şekillendirirken, Weizenbaum’un insani değerleri ön planda tutma çağrısını dikkate almalı ve teknolojinin insanlığın hizmetinde kullanılmasını sağlamalıyız.

ChatGPT ve benzeri araçların sunduğu olanakların yanında, Weizenbaum’un uyarılarını hatırlamak ve yapay zekanın etik boyutunu sürekli olarak sorgulamak, gelecekte karşılaşabileceğimiz potansiyel tehlikeleri önlemek için önemli bir adımdır. Teknolojik gelişmeleri insanlığın iyiliği için kullanmak, bizim sorumluluğumuzdur.

| Weizenbaum’un Ana Kaygıları | Günümüzdeki Yansımaları |

|---|---|

| İnsanların makinelere aşırı güvenmesi ve duygusal bağlanması | ChatGPT ve benzeri araçlara duyulan aşırı güven ve duygusal bağlanma |

| Yapay zekanın önyargıları yansıtması ve ayrımcılık yapması | Yapay zeka sistemlerindeki önyargı ve ayrımcılık sorunları |

| Teknolojinin insan kontrolünden çıkması | Yapay zekanın otonomlaşması ve insan müdahalesinin azalması riski |

| İnsani değerlerin arka plana itilmesi | Yapay zeka uygulamalarında etik değerlerin göz ardı edilmesi riski |